Learn More and Get Started with CUDA Programming

With the CUDA Toolkit properly installed, an exciting world of GPU-accelerated computing is now open to you.

Some helpful next steps:

- Try out the CUDA Sample programs included in the Toolkit installation.

- Walk through the CUDA Programming Guide for a comprehensive tutorial.

- Refer to the official CUDA Documentation for API references and expert guides.

- Join the CUDA Developer Forums to engage with the CUDA community.

- Stay updated on the NVIDIA Developer Blog covering cutting-edge GPU computing applications.

I hope this detailed guide helped demystify the process for installing the NVIDIA CUDA Toolkit on your system. The remarkable acceleration and performance benefits unlocked by CUDA are now at your fingertips. Happy coding!

Как производятся многопотоковые вычисления на видеокартах Nvidia?

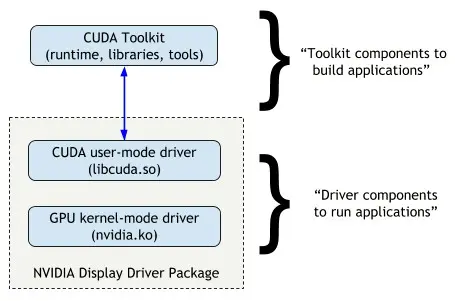

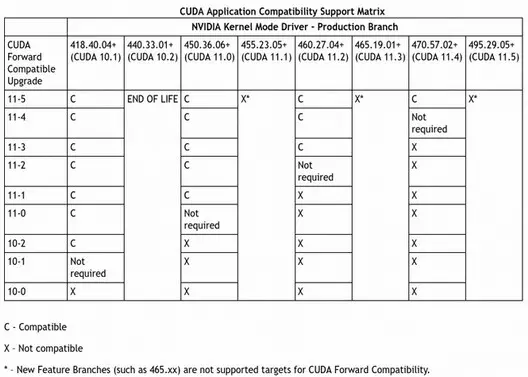

Для работы CUDA приложений на компьютере нужно иметь CUDA-видеокарту и драйвер дисплея NVIDIA, совместимый с CUDA Toolkit, использовавшийся при компиляции приложения (майнера):

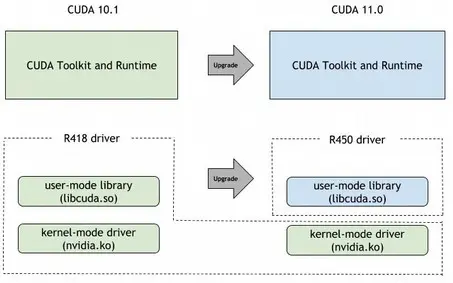

Для обеспечения совместимости каждая версия CUDA toolkit поставляется с подходящим драйвером дисплея NVIDIA. Пакет с драйверами включает в себя user mode CUDA-драйвер (файл libcuda.so) и компоненты ядра, что позволяет обеспечить работу всех функций, поддерживаемых в конкретной версии CUDA Toolkit.

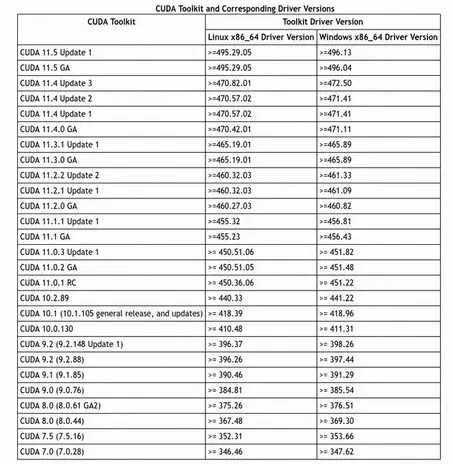

Программы, скомпилированные для более ранней версии CUDA должны успешно работать и с новыми драйверами. Приложение, скомпилированное с более поздней версией CUDA, чем та, что поддерживается драйверами, работать не будет.

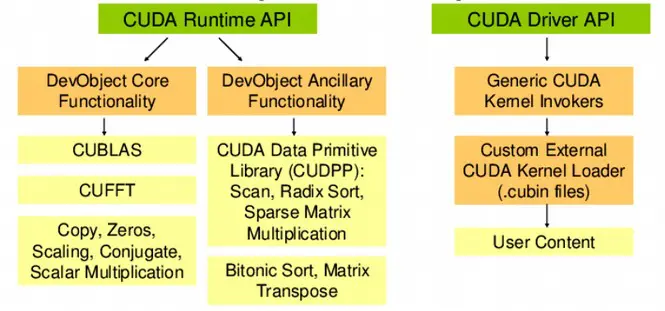

Работа CUDA-программ осуществляется с помощью двух интерфейсов прикладного программирования (API):

- высокого уровня (CUDA Runtime API);

- низкого уровня (CUDA Driver API).

Майнер или другая программа, использующая мультипроцессоры Nvidia, работает на основе CUDA Runtime API, поверх низкого уровня CUDA-драйверов:

Вызовы runtime-кода программы транслируются в более простые инструкции, в свою очередь обрабатываемые низкоуровневым API-драйвером.

Для успешного запуска майнера или другой программы, требующей поддержки CUDA, нужно:

- использовать драйвер, поддерживающий версию CUDA, равную или новее той, которая использовалась при компиляции;

- обеспечить, чтобы версия CUDA runtime, установленной в системе была не старее версии CUDA-драйвера.

Если программа (майнер) скомпилирована для более новой версии CUDA, чем та, что поставляется в драйверах, то (иногда) можно повысить только версию CUDA runtime, не трогая драйверов (эта фишка доступна для версий CUDA новее 10.0):

Это длается с помощью специального «CUDA compat package» на NGC-Ready профессиональных видеокартах Nvidia, но, возможно, при «определенной сноровке», применимо и на других моделях.

Если после успешной установки драйверов программа (майнер) не видит графического ускорителя, выдавая ошибку No Nvidia CUDA GPU detected, скорее всего не срабатывает CUDA runtime (так как система видит видеокарту, то значит функция deviceQueryDrv, реализуемая драйвером API работает нормально). Возможно, проблема кроется в неправильном взаимодействии с NVML-библиотекой, которая выдает неверную информацию о неподдерживаемом GPU.

2.4 A PC reboot after installation of Visual Studio May be Required

After installing Visual Studio, I initially moved straight on to downloading and attempting to install CUDA Toolkit for Windows — that step is Step 3 which I will be describing next. I got a message that Visual Studio was still operating and was preventing the installation of CUDA Toolkit. Rebooting my PC before attempting to install CUDA Toolkit again solved this problem.

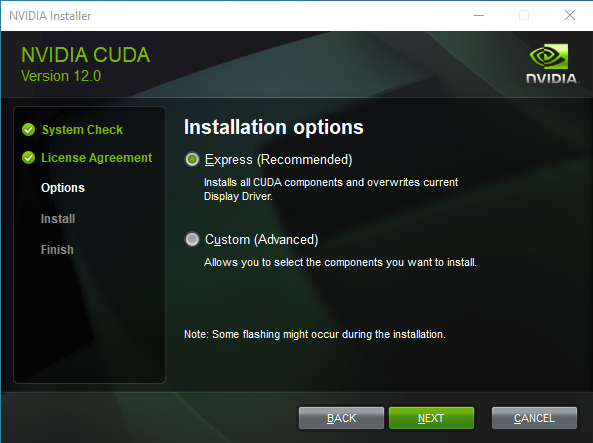

Step 3: Download CUDA Toolkit for Windows 10

These CUDA installation steps are loosely based on the Nvidia CUDA installation guide for windows. The CUDA Toolkit (free) can be downloaded from the Nvidia website here.

At the original time of writing this tutorial, the default version of CUDA Toolkit offered is version 10.0, as shown in Fig 6. However, you should check which version of CUDA Toolkit you choose for download and installation to ensure compatibility with Tensorflow (looking ahead to Step 7 of this process). When you go onto the Tensorflow website, the latest version of Tensorflow available (1.12.0) requires CUDA 9.0, not CUDA 10.0. To find CUDA 9.0 or any earlier releases, you need to navigate to the “Legacy Releases” on the bottom right hand side of Fig 6.

Fig 6: The default (most recent) version of CUDA for Windows at that point in time is cuda_10.0.130_411.31_win10.exe. For CUDA 9.0, choose “Legacy Releases”

Основные проблемы и их решение при установке CUDA

Установка CUDA на видеокарту NVIDIA может столкнуться с некоторыми проблемами, которые могут затруднить процесс и требовать дополнительных действий с вашей стороны. Ниже представлены некоторые из самых распространенных проблем и их решений.

1. Версия драйвера NVIDIA несовместима с CUDA

Одной из основных причин проблем при установке CUDA является несовместимость версий драйвера NVIDIA и CUDA Toolkit. Чтобы решить эту проблему, вам следует убедиться, что используется версия драйвера, которая поддерживает вашу версию CUDA Toolkit.

2. Отсутствие необходимого оборудования

Для использования CUDA необходима поддерживаемая видеокарта NVIDIA. Если у вас нет совместимой видеокарты, CUDA не будет работать. Убедитесь, что ваша видеокарта соответствует требованиям CUDA Toolkit.

3. Ошибки компиляции программы

При написании программы, использующей CUDA, могут возникать ошибки компиляции. В этом случае вам потребуется проверить код и убедиться, что он соответствует синтаксическим требованиям CUDA C/C++ и правильно использует функции и переменные.

4. Ошибки времени выполнения

При запуске программы, использующей CUDA, могут возникать ошибки времени выполнения, связанные с неправильной конфигурацией или использованием функций CUDA. В этом случае вам следует проверить конфигурацию устройства и оценить правильность использования функций CUDA.

5. Ограничения операционной системы

Некоторые операционные системы могут иметь ограничения, которые могут затруднить установку или использование CUDA. Убедитесь, что вы используете поддерживаемую версию операционной системы и настройте ее соответствующим образом для работы с CUDA.

Важно помнить, что процесс установки и настройки CUDA может отличаться в зависимости от вашей конкретной ситуации. В случае возникновения проблем рекомендуется обратиться к документации NVIDIA или сообществу разработчиков CUDA для получения дополнительной помощи

Step 7.2: System wide install of Tensorflow via python pip

Having opened the Command Prompt, the system-wide installation command for Tensorflow with GPU support is as follows:

pip3 install --upgrade tensorflow-gpu

The “pip3” command (as opposed to “pip”) is required as the installation is to Python 3. Execution of this command in the command prompt is shown in Fig 22.

Fig 22: Pip install command for Tensorflow with GPU support

The resulting output from the command is shown in Fig 23, and if all goes to plan there should eventually be a message to confirm that Tensorflow has been installed successfully.

Fig 23: Command prompt messages shown when Tensorflow GPU 1.12.0 installed successfully.

Step 8: Test Installation of TensorFlow and its access to GPU

Go to the start menu in windows and search for the IDE called ‘idle’, which will be installed as part of your python installation if you selected as I did at Step 6. A Python window should appear labelled Python 3.6.x Shell. At the prompt (denoted by ‘>>>’), import the Tensorflow package. This will check that Tensorflow has been installed (as you can import it). The command for the IDLE shell to import the tensorflow package is as follows:

# importing the tensorflow package import tensorflow as tf

To test CUDA support for your Tensorflow installation, you can run the following command in the shell:

tf.test.is_built_with_cuda()

Finally, to confirm that the GPU is available to Tensorflow, you can test using a built-in utility function in TensorFlow as shown here:

tf.test.is_gpu_available(cuda_only=False, min_cuda_compute_capability=None)

It takes a few minutes to return a result from this; when it is finished it returns True, and then the prompt `>>>`appears again. Importing tensorflow and these tests are all shown in Fig 24 in the Python IDLE Shell.

Fig 24: Using the IDLE python IDE to check that Tensorflow has been built with CUDA and that the GPU is available

Conclusions

These were the steps I took to install Visual Studio, CUDA Toolkit, CuDNN and Python 3.6, all with the ultimate aim of installing Tensorflow with GPU support on Windows 10. To date, my GPU based machine learning and deep learning work has been on Linux Ubuntu machines; by the same token, much of the machine learning community support online focuses on Ubuntu.

For Machine Learning, the major drawback to using Windows is that it is necessary to build more things from source (for example using Cmake) than on Linux, and also to install additional software for the build processes, such as Visual Studio. For example, if you were to install Caffe2 on Windows, there are no pre-built binaries and Windows build is in testing and beta mode. I installed CUDA and cuDNN on Windows 10 more out of curiosity than anything else, just to see how straightforward (or otherwise) it was.

As I suggested in , now that CUDA, cuDNN and Tensorflow are successfully installed on Windows 10 and I have checked Tensorflow’s access to GPU, I am going to sweep the whole Windows 10 operating system away in order to make a fresh installation of Ubuntu 18.04 LTS. This new installation of Ubuntu will be covered in Part 3 of this series.

CUDA и язык C:

- Спецификаторы функций, которые показывают, как и откуда буду выполняться функции.

- Спецификаторы переменных, которые служат для указания типа используемой памяти GPU.

- Спецификаторы запуска ядра GPU.

- Встроенные переменные для идентификации нитей, блоков и др. параметров при исполнении кода в ядре GPU .

- Дополнительные типы переменных.

- __host__ — выполнятся на CPU, вызывается с CPU (в принципе его можно и не указывать).

- __global__ — выполняется на GPU, вызывается с CPU.

- __device__ — выполняется на GPU, вызывается с GPU.

- gridSize – размерность сетки блоков (dim3), выделенную для расчетов,

- blockSize – размер блока (dim3), выделенного для расчетов,

- sharedMemSize – размер дополнительной памяти, выделяемой при запуске ядра,

- cudaStream – переменная cudaStream_t, задающая поток, в котором будет произведен вызов.

- gridDim – размерность грида, имеет тип dim3. Позволяет узнать размер гридa, выделенного при текущем вызове ядра.

- blockDim – размерность блока, так же имеет тип dim3. Позволяет узнать размер блока, выделенного при текущем вызове ядра.

- blockIdx – индекс текущего блока в вычислении на GPU, имеет тип uint3.

- threadIdx – индекс текущей нити в вычислении на GPU, имеет тип uint3.

- warpSize – размер warp’а, имеет тип int (сам еще не пробовал использовать).

Дополнительные типы переменных и их спецификаторы будут рассмотрены непосредственно в примерах работы с памятью.

Как создавать проекты CUDA в Visual Studio и запускать примеры из книги

В VS при создании нового проекта выбираем тип NVIDIA/CUDA 6.0 и из шаблонов: CUDA Runtime 6.0.

После этого VS формирует заготовку проекта, содержащую единственный исходный файл kernel.cu . Он нам не нужен. Вместо него вставляем пример из книги:

Расширение файла .CU имеет значение! Только в таких файлах можно пользоваться CUDA-расширениями языка C++.

Чтобы настроить подсветку синтаксиса в файлах .CU как в C++, нужно в окне Tools -> Options -> Text Editor -> File Extension указать расширение .cu и в списке Editor: — Microsoft Visual C++. После перезапуска VS получим подсветку синтаксиса.

Для исправления нужно добавить квалификатор __device__ в конструктор структуры:

Extra Step: Install Python PIP And Tools

Install Third-Party Libraries For More Features With CUDA

# apt install g++ freeglut3-dev build-essential libx11-dev libxmu-dev libxi-dev libglu1-mesa libglu1-mesa-dev libfreeimage-dev

Get Information About Your GPU

# apt install hwinfo # hwinfo --gfxcard --short # lshw -C display # nvidia-smi

Note That: If you are not the root user while using nvcc or CUDA tools, you will need to sudo commands to be run as the superuser, and we need to append the CUDA tools bin directory /usr/local/cuda/bin to the secure_path value at the /etc/sudoers file.

# visudo /etc/sudoers ~~~~ # # This file MUST be edited with the 'visudo' command as root. # # Please consider adding local content in /etc/sudoers.d/ instead of # directly modifying this file. # # See the man page for details on how to write a sudoers file. # Defaults env_reset Defaults mail_badpass Defaults secure_path="/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/snap/bin:/usr/local/cuda/bin" # Host alias specification ~~~~

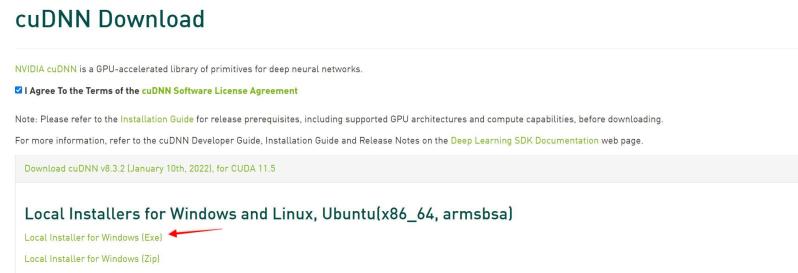

Install cuDNN –

Next, we need to install cuDNN. The NVIDIA CUDA Deep Neural Network library (cuDNN) is a GPU-accelerated library of primitives for deep neural networks. cuDNN provides highly tuned implementations for standard routines such as forward and backward convolution, pooling, normalization, and activation layers.

Go to the following link and download cuDNN, you will be asked to create an account first. It’s completely free, so need to worry about it. –

Download the exe file and then double click to install it.

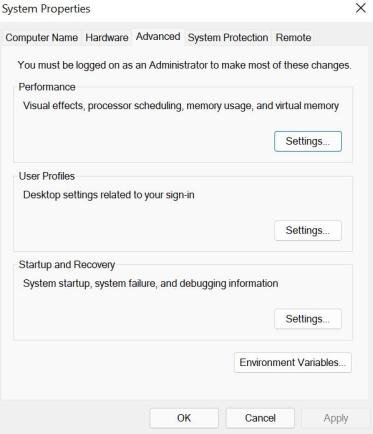

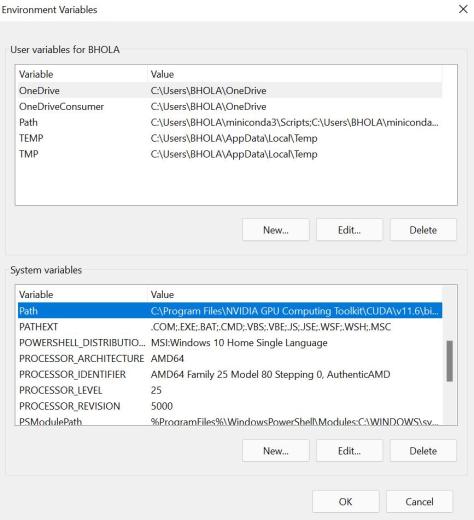

Set Environment Variables –

Next, we need to set up Environment Variable.

Go to control panel > System and Security > System > Advanced System Settings. Then click on environment variables.

Now, we need to add 4 paths to the system variables. First, go to the C drive where Nvidia Cuda Toolkit is installed. In my system it’s inside – C:\Program Files\NVIDIA GPU Computing Toolkit. And the cuDNN is installed inside – C:\Program Files\NVIDIA\CUDNN . Please check yours, it probably will be the same but still, make sure.

Select path inside System variable and click on edit.

Then click on new and add the following paths one by one. Some of them are already added when you installed them. So, add the remaining that is left.

Once all added. click ok and exit all dialog boxes.

Как избавиться от ошибки CUDA device not found?

Перед поиском причин ошибки CUDA device not found нужно убедиться, что видеокарта, установленная на компьютере, поддерживается программой, которая выдает ошибку.

Иногда может возникнуть ситуация, когда пользователь пытается запустить новый майнер на устаревшей (с точки зрения разработчика) видеокарте. В этом случае проблему можно решить компиляцией майнера под нужную версию CUDA (при наличии исходного кода), либо использовать другой, совместимый майнер.

В дистрибутивах Windows и в OS с Linux-ядром проблема с определением CUDA-устройтсв обычно успешно решается с помощью повторной установки нужных драйверов, желательно с полной очисткой от предыдущих. Дополнительно можно вручную инсталлировать CUDA Toolkit, соответствующий установленной версии драйверов или новее.

Тем не менее, в некоторых, особенно тяжелых случаях такие манипуляции не помогают и система упорно отказывается признавать наличие видеокарты, способной производить compute-вычисления.

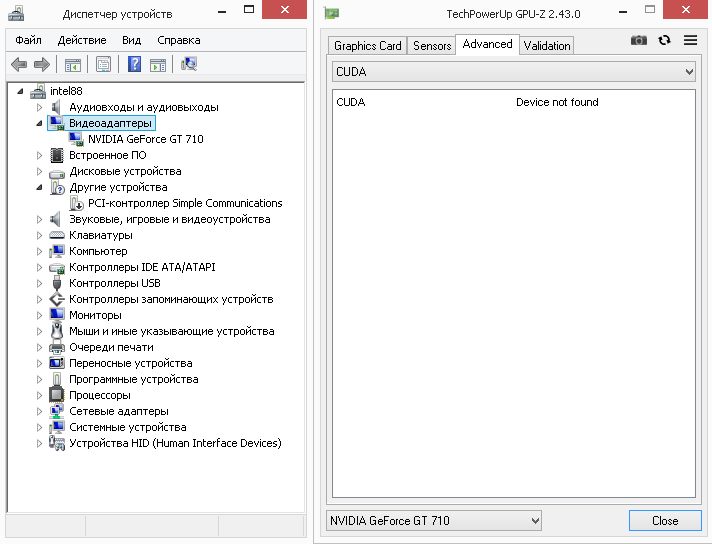

Пример отображения информации в программе GPU-Z на компьютере с видеокартой Nvidia GT710 (ОС Windows 8.1, драйвера успешно установлены), но CUDA-устройства пребывают в состоянии невидимости:

Для решения проблемы можно предпринять следующие шаги:

- проверить в диспетчере устройств установку драйверов для всех устройств (отсутствие восклицательных знаков или ошибок);

- запуск программы осуществлять от имени администратора (не из гостевого аккаунта);

- поставить совместимые драйвера более новой версии после очистки от предыдущих с помощью программы DDU (Display Driver Uninstaller);

- на компьютер дополнительно установить другой видеоакселератор и поставить драйвер;

- установить видеокарту в другой слот PCI-E материнской платы или райзер;

- включить видимость CUDA-устройства с помощью переменной окружения CUDA_VISIBLE_DEVICES (об этом ниже по тексту);

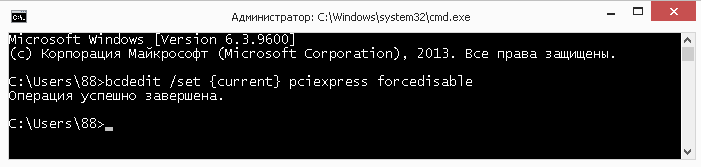

- отключить функцию PCI Express Native Control Feature. Для этого нужно выполнить из-под админа консольную команду:

bcdedit /set {current} pciexpress forcedisable

перезагрузить систему и заново установить драйвера

произвести переустановку операционной системы.

Иногда перечисленные ухищрения не срабатывают и, хотя видеокарта Nvidia успешно определяется операционной системой, видна в диспетчере задач Windows, она не работает как CUDA-устройство.

При загрузке этого же компьютера с операционной системой на Linux-ядре (xubuntu 18.04), видеокарта успешно работает, производя многопотоковые вычисления при майнинге.

Исходя из успешной работы видеокарты в ОС Linux, можно сделать предположение, что она исправна и на компьютере используются правильные настройки BIOS. Вероятно, решение проблемы с невидимостью CUDA связано с конфигурацией конкретного дистрибутива Windows.

Install NVIDIA CUDA on Ubuntu 22.04 or 20.04 via CUDA APT PPA

As previously discussed, installing CUDA directly from the NVIDIA CUDA repository is the most efficient approach. This method ensures you’ll be the first to receive any new enhancements, bug fixes, security updates, or features.

Step 1: Preparing Your System for NVIDIA CUDA PPA on Ubuntu

Before diving into the installation process, we must ensure your system is ready. This involves installing several necessary packages. These packages might already be on your system, but double-checking doesn’t hurt. Run the following command in your terminal:

This command installs several packages that are essential for the following steps. These packages include (for managing keys), (for handling SSL certificates), (for managing software repositories), (for secure package downloads), (for managing kernel modules), and (for downloading files from the internet).

Step 2: Import GPG Key for NVIDIA PPA on Ubuntu 22.04 or 20.04

Security takes top priority during software installations. To verify the authenticity and integrity of the packages we want to install, we must import the GPG key for our specific distribution version. The repository uses this key to sign the packages. We instruct our system to trust packages that this key has signed by importing it.

For Ubuntu 22.04 Jammy Jellyfish release, use the following command:

For Ubuntu 20.04 Focal Fossa release, use this command instead:

Step 3: Import NVIDIA Repository to Your Ubuntu System

With the GPG key in place, we can now add the NVIDIA repository to our system. This repository contains the packages we need for our CUDA installation.

For Ubuntu 22.04 Jammy Jellyfish release, use the following command:

For Ubuntu 20.04 Focal Fossa release, use this command instead:

Step 4: Refreshing the Package List for NVIDIA Cuda PPA

Now that we’ve added the NVIDIA repository, we must update our system’s package list. This ensures that our system knows the new packages available in the NVIDIA repository. To do this, run the following command:

This command fetches the latest package information from all configured repositories, including the newly added NVIDIA repository.

Step 5: Install CUDA Toolkit on Ubuntu 22.04 or 20.04

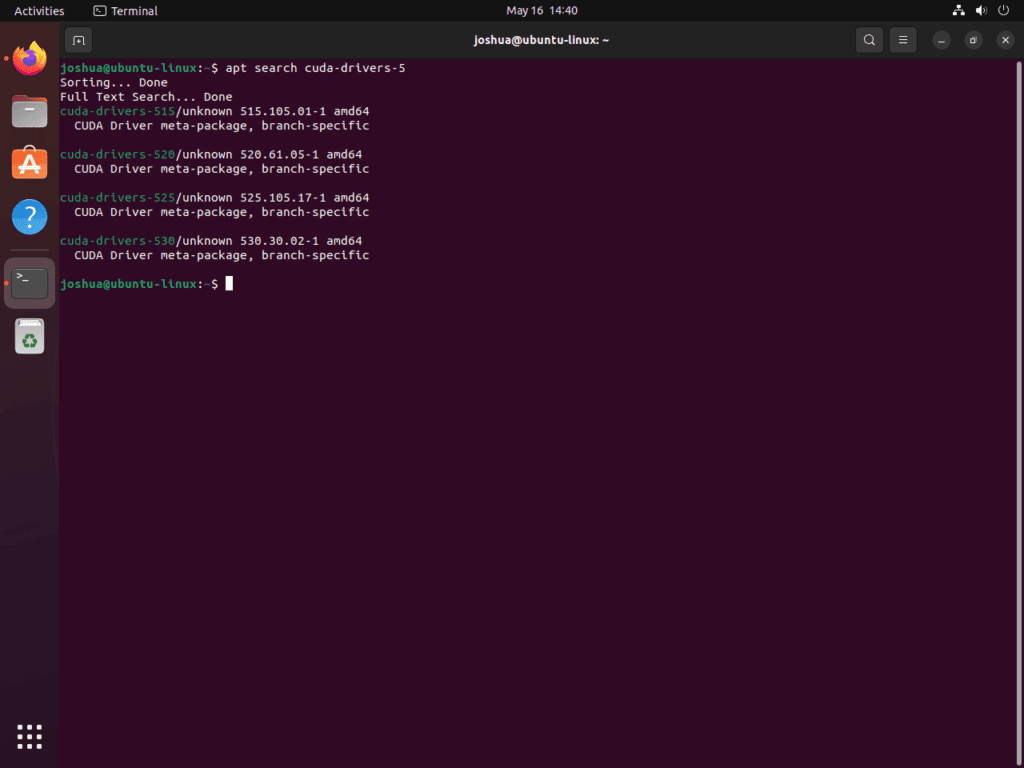

We can install CUDA with the latest NVIDIA drivers with everything set up. But before we do that, it’s a good idea to check the available driver versions. You can do this using the APT search command:

Example of how to locate NVIDIA CUDA drivers using the apt command on Ubuntu 22.04 or 20.04 Linux.

Example of how to locate NVIDIA CUDA drivers using the apt command on Ubuntu 22.04 or 20.04 Linux.

This command lists all the available CUDA versions. You can choose the one that suits your needs best. For the purpose of this guide, we’ll demonstrate how to install the latest version currently available.

Remember to replace with , , , etc., depending on your preference.

Once installed, you will need to reboot your system:

Is CUDA Driver Different from NVIDIA Driver?

I have found that libcuda. So, it is a part of the NVIDIA driver and is installed when CUDA drivers are installed. Hence, you can say that CUDA drivers or libcuda are part of NVIDIA GPU drivers. NVIDIA drivers enable your CUDA because they contain CUDA real-time API, user libraries, kernel modules, etc.

On the other hand, CUDA Toolkit is a Software Development Kit (SDK) that allows you to build GPU-accelerated application software. It is why it contains documentation, libraries, a compiler, and API (application programming interface). CUDA Toolkit is different from NVIDIA drivers because it needs an IDE.

Настройка CUDA на Linux: пошаговая инструкция

Шаг 1: Установка драйверов NVIDIA

Перед установкой CUDA необходимо убедиться, что у вас установлены драйверы NVIDIA совместимой версии. Вы можете установить их вручную с официального сайта NVIDIA или использовать менеджер пакетов вашего дистрибутива.

Шаг 2: Проверка поддержки вашего устройства

Перед установкой CUDA также рекомендуется проверить, поддерживается ли ваше устройство NVIDIA. Вы можете найти список поддерживаемых устройств на сайте разработчика CUDA. Это поможет вам выбрать подходящую версию CUDA для установки.

Шаг 3: Скачивание пакета CUDA

После установки драйверов и проверки поддержки вашего устройства, вы можете скачать пакет CUDA с официального сайта разработчика. Вам понадобится выбрать текущую версию CUDA и правильное расположение, в зависимости от вашей операционной системы и архитектуры.

Шаг 4: Установка CUDA

После скачивания пакета CUDA вам нужно выполнить его установку. Запустите установочный скрипт из командной строки с правами администратора и следуйте инструкциям на экране. Установщик сможет автоматически настроить вашу операционную систему и установить необходимые компоненты.

Шаг 5: Настройка переменных среды

После установки CUDA вам необходимо настроить переменные среды. Добавьте следующую строку в ваш файл .bashrc или .bash_profile:

export PATH=/usr/local/cuda/bin${PATH:+:${PATH}}

Обновите переменные среды, выполнив команду:

source ~/.bashrc

Шаг 6: Проверка установки

Чтобы проверить правильность установки CUDA, выполните следующую команду:

nvcc -V

Если вы видите информацию о версии CUDA-компилятора без ошибок, значит, установка прошла успешно.

Теперь вы можете начать использовать инструментарий CUDA для своих вычислительных задач на Linux. Не забудьте также установить соответствующие библиотеки и инструменты разработки для работы с CUDA.

Как установить драйвер сетевой карты на чипе rtl8821ce?¶

К сожалению, Wi-Fi модули на базе чипа rtl8821ce входят , поэтому для их корректной работы необходимо установить сторонний драйвер при помощи .

Отключим технологию , т.к. она полностью блокирует возможность загрузки неподписанных модулей.

Произведём полное до актуальной версии:

sudo dnf upgrade --refresh

Установим пакеты git, dkms, компилятор GCC, а также исходники и заголовочные файлы ядра Linux:

sudo dnf install git gcc dkms kernel-devel kernel-headers

Загрузим rtl8821ce с GitHub:

git clone --depth=1 https://github.com/tomaspinho/rtl8821ce.git rtl8821ce

Скопируем содержимое в общий каталог хранения исходников, где они будут доступны для dkms:

sudo cp -r rtl8821ce /usr/src/rtl8821ce-v5.5.2_34066.20200325

Запустим сборку модуля ядра и установим его:

sudo dkms add -m rtl8821ce -v v5.5.2_34066.20200325 sudo dkms build -m rtl8821ce -v v5.5.2_34066.20200325 sudo dkms install -m rtl8821ce -v v5.5.2_34066.20200325

Здесь v5.5.2_34066.20200325 – версия модуля rtl8821ce, которая может быть получена из файла (без учёта суффикса BTCOEXVERSION).

Перезагрузим систему для вступления изменений в силу:

sudo systemctl reboot

Этап 2: Включение CUDA

Включить рассматриваемую технологию разом для всех программ не получится – необходимо её выбирать либо перед началом работы, либо в процессе, либо перед непосредственно вычислением. Использование данного средства покажем на примере программы Adobe After Effects последней версии.

- Запустите Афтер Эффектс и выберите пункты «Файл» – «Создать» – «Создать проект».

В других приложениях данная технология активируется подобным образом.

Мы рады, что смогли помочь Вам в решении проблемы.

Опишите, что у вас не получилось. Наши специалисты постараются ответить максимально быстро.

Это первая публикация из цикла статей об использовании GPGPU и nVidia CUDA. Планирую писать не очень объемно, чтобы не слишком утомлять читателей, но достаточно часто. Я предполагаю, что читатель осведомлен, что такое CUDA, если нет, то вводную статью можно найти на Хабре.

Как прописать список поддерживаемых монитором разрешений?¶

Создадим отдельный файл конфигурации для монитора в каталоге и пропишем доступные разрешения и используемый драйвер.

Сначала посредством запуска утилиты cvt вычислим значение строки для требуемого разрешения:

cvt 1920 1080 60

Здесь 1920 – разрешение по горизонтали, 1080 – по вертикали, а 60 – частота регенерации.

Теперь создадим конфиг следующего содержания:

Section "Monitor"

Identifier "VGA1"

Modeline "1920x1080_60.00" 173.00 1920 2048 2248 2576 1080 1083 1088 1120 -hsync +vsync

Option "PreferredMode" "1920x1080_60.00"

EndSection

Section "Screen"

Identifier "Screen0"

Monitor "VGA1"

DefaultDepth 24

SubSection "Display"

Modes "1920x1080_60.00"

EndSubSection

EndSection

Section "Device"

Identifier "Device0"

Driver "intel"

EndSection

4 ответа 4

Использование браузера для поиска CUDA

Если отображается 0, возможно, оборудование по-прежнему поддерживает CUDA, но драйверы просто не установлены/не работают. На моем ноутбуке отображается 0, но GPU-Z говорит, что мое оборудование поддерживает CUDA 1.2

Список поддерживаемых графических карт см. в Википедии.

Вы не говорили мне об этом раньше. Какой у вас производитель и модель материнской платы? У него есть графический процессор Nvidia?

API программного обеспечения CUDA поддерживается графическими процессорами Nvidia с помощью программных драйверов, предоставляемых Nvidia.

- Чтобы скомпилировать приложение CUDA специально для вашего графического процессора, требуются вычислительные возможности конкретного графического процессора, и это можно получить, выполнив шаги, описанные в

(Я автор этого веб-инструмента)

Вручную вы можете использовать nvidia-smi, который устанавливается вместе с драйвером

Или используйте информацию о драйвере, чтобы получить имя графического процессора и сопоставить его с вычислительными возможностями.

Если вы используете терминал, команда nvidia-smi очень удобна для получения информации о модели вашего графического процессора, версии CUDA и версии драйвера NVIDIA.

Вам потребуется выполнить следующие проверки:

- Используйте модель графического процессора, чтобы получить вычислительные возможности графического процессора. NVIDIA предоставляет список здесь.

- Проверьте версию установленного драйвера по выходным данным nvidia-smi.

- Проверьте установленную версию CUDA по выходным данным nvidia-smi.

Для (1) в идеале GPU должен иметь вычислительную мощность не ниже 3.0, чтобы он мог работать с функциями CUDA для глубокого обучения. Впоследствии проверьте установленную версию CUDA и возможное обновление. Существует «ограничение» пути обновления, особенно для старых моделей графических процессоров. Возможно, вам не удастся выполнить обновление до последней версии CUDA, поскольку каждая версия CUDA имеет минимальные вычислительные возможности, которые она поддерживает.

Вы можете проверить таблицу совместимости CUDA и минимальный драйвер дисплея, поддерживаемый каждой версией, здесь.

-

Разгон видеокарты nvidia geforce gtx 650 ti

-

Как включить ускоренный режим на видеокарте

-

Замена оперативной памяти Samsung n150

-

Производитель процессорного оборудования

- Что такое интерфейс памяти видеокарты

What is NVIDIA CUDA Toolkit?

The NVIDIA CUDA Toolkit provides a development environment for creating high performance GPU-accelerated applications. It allows developers to harness the parallel processing capabilities of NVIDIA GPUs for significant performance improvements compared to CPU-only workflows.

Here are some of the key components included in the CUDA Toolkit:

- CUDA Driver API and Runtime: This enables direct access to the GPU’s virtual instruction set and parallel computational elements.

- Compilers: NVCC compiler for CUDA C/C++ programming. OpenACC, OpenMP, and MPI support.

- Math Libraries: BLAS, FFT, RNG, and other GPU-accelerated math libraries.

- Development Tools: NVIDIA Nsight IDE, debugger, profiler and more.

- Code Samples and Documentation: Everything you need to start CUDA development.

By providing essential GPU acceleration enablers like the CUDA parallel computing platform and programming model, the CUDA Toolkit empowers developers to solve complex computational challenges faster and more efficiently.

Key Benefits of the CUDA Toolkit

- Achieve massive performance improvements with parallel processing on GPUs.

- Write CUDA C/C++ code for GPU acceleration without specialized skills.

- Port existing C/C++ code to run on GPUs.

- Analyze and optimize CUDA applications for maximal efficiency.

- Develop, debug and profile seamlessly in familiar environments.

Как включить автоматическое подключение Bluetooth устройств при загрузке?¶

Включим автоматический запуск systemd-юнита:

sudo systemctl enable --now bluetooth.service

Отредактируем файл конфигурации :

sudoedit /etc/bluetooth/main.conf

Активируем автоматическое подключение доверенных устройств при запуске:

AutoEnable=true

Любым способом определим HW-адрес устройства (отображается как при поиске, так и в списке подключённых), затем войдём в консоль настройки Blueooth сервера:

bluetoothctl

Получим список сопряжённых устройств:

paired-devices

Если нужное нам оборудование c HW AA:BB:CC:DD:EE:FF уже числится в списке, удалим его:

remove AA:BB:CC:DD:EE:FF

Запустим процесс поиска новых устройств, убедимся, что девайс обнаруживается, затем отключим его:

scan on scan off

Назначим доверенным:

trust AA:BB:CC:DD:EE:FF

Произведём сопряжение и осуществим подключение:

pair AA:BB:CC:DD:EE:FF connect AA:BB:CC:DD:EE:FF

Как проверить, поддерживается ли у вас CUDA?

Прежде чем приступить к установке CUDA на Windows 10, необходимо проверить, поддерживается ли ваш компьютер данной технологией. Вот несколько способов, которые помогут вам узнать, подходит ли ваша система для работы с CUDA:

- Убедитесь, что у вас установлена подходящая версия графического драйвера. CUDA требует наличия драйвера, который поддерживает данную технологию. Проверьте сайт производителя вашей видеокарты для получения информации о поддержке CUDA и загрузите соответствующий драйвер, если необходимо.

- Проверьте наличие совместимой видеокарты. CUDA поддерживает только определенные модели видеокарт, поэтому вам следует проверить, поддерживает ли ваша видеокарта технологию CUDA. Обычно эту информацию можно найти на сайте производителя или в документации к видеокарте.

- Используйте инструмент CUDA-Z для проверки поддержки CUDA на вашей системе. CUDA-Z — это бесплатное программное обеспечение, которое позволяет узнать подробную информацию о поддержке CUDA на вашем компьютере.

- Если у вас возникли трудности или вы не уверены в том, поддерживается ли CUDA на вашей системе, вы можете обратиться к технической поддержке производителя вашей видеокарты или посетить форумы, где пользователи делятся своим опытом использования CUDA на различных конфигурациях системы.

Проверка совместимости и поддержки CUDA на вашей системе является важным шагом перед началом установки технологии и позволяет избежать проблем в процессе работы. Убедитесь, что вы выполнили все необходимые проверки перед установкой CUDA на Windows 10.

Are CUDA and GPU the Same?

GPU is the abbreviation of a Graphics processing unit, also known as a graphics card. A graphics card is installed in your computer system, and it is hardware like RAM or SSD. But the GPU is way more significant than the RAM and has two or three fans. Small motherboards have a GPU with no or single fan.

The most visible sign of your GPU is that your display monitor(s) is connected to it at the back of your computer system’s case. NVIDIA is the most popular company for manufacturing GPUs, and in this case, your operating system (OS) will have an NVIDIA control panel installed on your computer system.

On the other hand, the term CDAU is used for three different entities. The first one is the CUDA cores. These cores are smaller and dedicated graphics processing units, and a GPU has hundreds or even thousands of these cores. The second CUDA term is used for the device drivers that allow you to use these cores.

The third CUDA is the toolkit developed by NVIDIA. It is an essential tool for developers to establish GPU-accelerated application programs. Most technical software developers use this free development toolkit. If you are a developer, you can download the CUDA Toolkit by clicking the link.

Step 7.1: Calling up the command prompt with administration rights

In this step a system-wide install of Tensorflow is carried out, not a per user install, but an alternative means of carrying out this tensorflow installation (not covered here) is to create a Python virtual environment, activate the environment and install Tensorflow within that environment.

If you wish to make a system wide installation of Tensorflow, this requires administrative rights, therefore, accordingly the command prompt should be run with administrative rights. To do this, open up the command prompt by running ‘’ in the search bar, and then right clicking on command prompt to choose ‘run as administrator’. This opens up Administrator: Command Prompt as shown in Fig 21.

Fig 21: Running the command prompt as administrator from the Windows 10 search bar